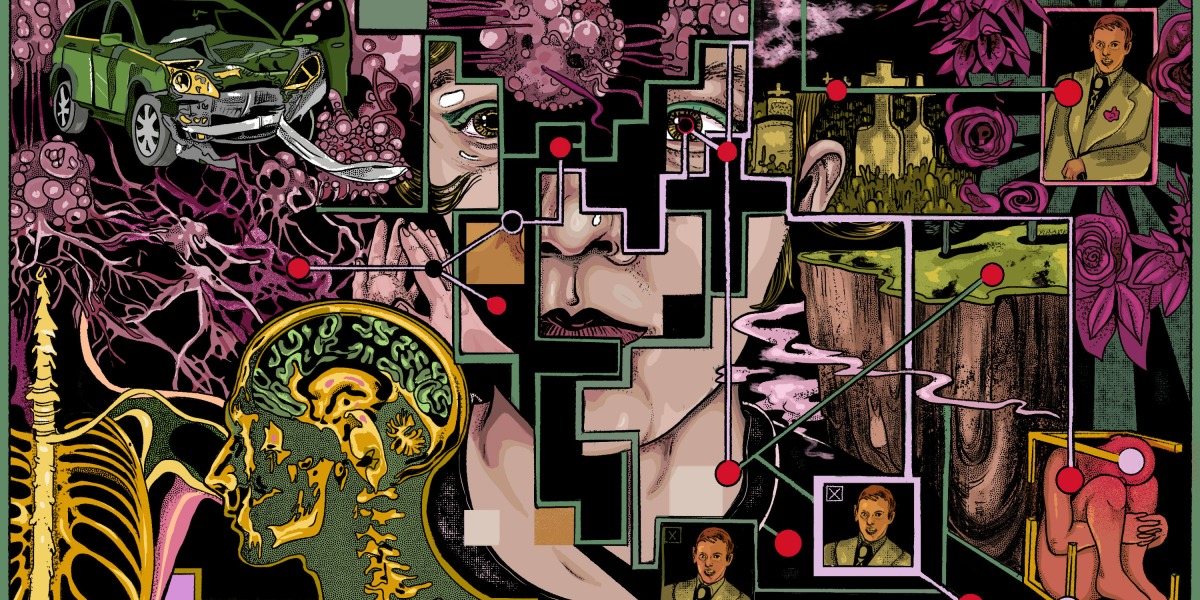

Keder algoritmaları ve görüntü AI gizlilik sorunları tarafından tuzağa düşürüldü

—Tate Ryan-Mosley, kıdemli teknoloji politikası muhabiri

Her zaman, olabilecek her şey hakkında elimden geldiğince çok şey öğrenmeye çalışarak belirsizlikle başa çıkan bir süper Google çalışanı oldum. Buna babamın gırtlak kanseri de dahildi.

iPhone’umdaki uygulamadan kederin aşamalarını, kayıpla ilgili kitapları ve akademik araştırmaları Google’da aramaya başladım, Instagram videoları, çeşitli haber kaynakları ve Twitter referansları aracılığıyla insanların keder ve trajedi deneyimlerini kasıtlı veya kasıtsız olarak tükettim.

Yine de her arama ve tıklamayla, istemeden yapışkan bir dijital keder ağı oluşturdum. Nihayetinde, algoritmaların bana hizmet ettiğinden kendimi çözmem neredeyse imkansız olacaktı. Çıktım – sonunda. Ancak, bizim için zararlı olsa bile, istemediğimiz içeriğin aboneliğini iptal etmek ve bu içeriğin kapsamı dışında kalmak neden bu kadar zor? Hikayenin tamamını okuyun.

AI modelleri, gerçek kişilerin fotoğraflarını ve telif hakkıyla korunan resimleri tükürür

Haberler: Yeni araştırmaya göre, görüntü oluşturma modellerinden gerçek kişilerin tanımlanabilir fotoğraflarını, tıbbi görüntüleri ve sanatçıların telif hakkıyla korunan çalışmalarını üretmeleri istenebilir.

Nasıl yaptılar: Araştırmacılar, Stable Diffusion ve Google’ın Imagen’e birçok kez resimler için, örneğin bir kişinin adı gibi altyazılar vermesini istedi. Ardından, oluşturulan görüntülerden herhangi birinin modelin veritabanındaki orijinal görüntülerle eşleşip eşleşmediğini analiz ettiler. Grup, AI’nın eğitim setinde 100’den fazla görüntü kopyası çıkarmayı başardı.

Neden önemli: Bulgu, şu anda AI şirketlerine telif hakkı ihlalleri nedeniyle dava açan sanatçıların durumunu güçlendirebilir ve insan deneklerin mahremiyetini potansiyel olarak tehdit edebilir. Ayrıca, bu sistemlerin hassas özel bilgileri sızdırma riski taşıdığını gösterdiğinden, sağlık hizmetlerinde üretken AI modellerini kullanmak isteyen girişimler için de etkileri olabilir. Hikayenin tamamını okuyun.